こんにちは。SPENDAの伊藤です。

情報があふれる今の時代では情報収集の方法が重要になっていますが、 RSSリーダーに多くのサイトを登録して、毎朝最新情報を順番にINPUTしている方も多いでしょう。

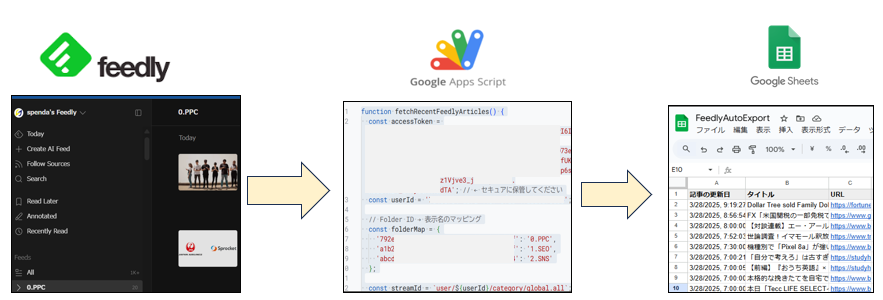

複数のサイトの中で更新情報だけ見れるツール例として、「Feedly」が情報収集の効率化ツールとして高い評価を得ています。弊社でも複数のWEBサイトをFeedlyに登録して、有料プランに入ってフォルダでジャンル別に管理することで活用してきました。

このFeedlyを使って、今後のさらなる効率化に向けて最新記事URLを自動でスプレッドシートに出力する方法を確立しようと思い、色々な方法を試してみました。

その結果、GASでコードを入力する方法が良いということが分かったのですが、その中で非エンジニアでもChat GPTなどAIツールに不明点を聞きながら進めれば問題なく設定できました。少し試行錯誤すれば誰でもできる方法なので、 今回はAIツールの活用方法と絡めてその手順を紹介します。

なぜ自動化が必要なのか? Feedly情報収集の課題

Feedlyは便利なRSSリーダーですが、登録サイトが増えると新着記事を追いかけるだけでも一苦労です。・気になる記事を見逃してしまう

・後で読もうと思った記事が埋もれてしまう

・記事のURLを一つ一つコピーして管理するのが面倒

これをもし、新着記事の情報が自動でスプレッドシートに一覧として出力されて、しかも毎朝同じ時間に自動で行われたらとても便利ですよね。

今のAI時代ならこれを実現できるのです。

その解決策とはGASでAPIを使って出力する方法です。

これはコードに詳しい人であれば以前からできることですが、AIチャットを利用して質問すれば非エンジニアでもできるのです。

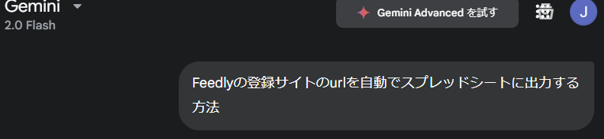

そもそも手順が分からないのでAIに質問

「Geminiにどのような順番で進めればよいか分からない」質問する」という場合に、最初にそれをGeminiに聞きます。 GeminiでなくてもAIツールのChat GPT、Copilotなど使い慣れたツールで良いでしょう。「Feedlyの登録サイトのURLを自動でスプレッドシートに出力する方法」など聞けば答えてくれますし、信ぴょう性を上げるには2,3つのツールに聞いて妥当そうな内容を見つけましょう。

失敗しても良い状況ならそれですぐに試して調整するのが良いですし、どこまで正確性を求めるかによってAIツールに聞く範囲を調整しましょう。

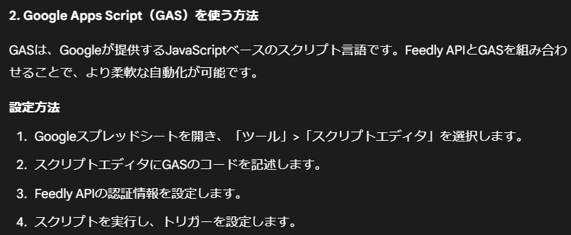

カスタムGPT「Sheets Maker」にGASコード作成を依頼

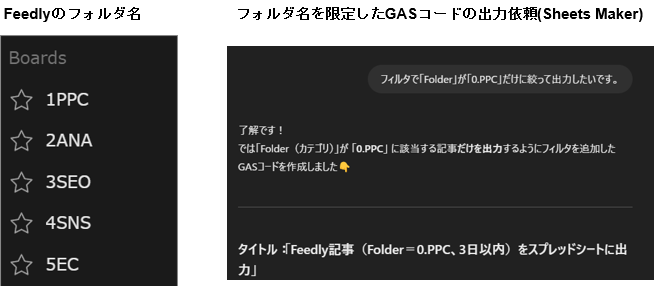

次に、ChatGPTのカスタムGPT「Sheets Maker」(※PRO版限定ですが、GPTsストアで見つけられます)に、Geminiで得た手順と具体的にやりたいこと(例:更新日、タイトル、URL、フォルダ名を指定して出力)を伝えて、GASコードのサンプルを作成してもらいます。

コード実行とエラー修正(ChatGPTとの対話が鍵)

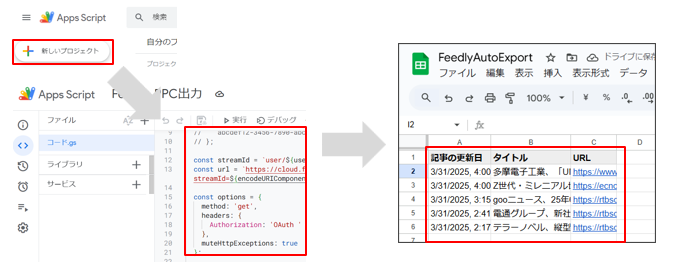

作成されたGASコードを、Googleスプレッドシートの「拡張機能」→「Apps Script」に貼り付けて実行します。しかし多くの場合は、最初から完璧に動くコードが出てくるわけではありません。

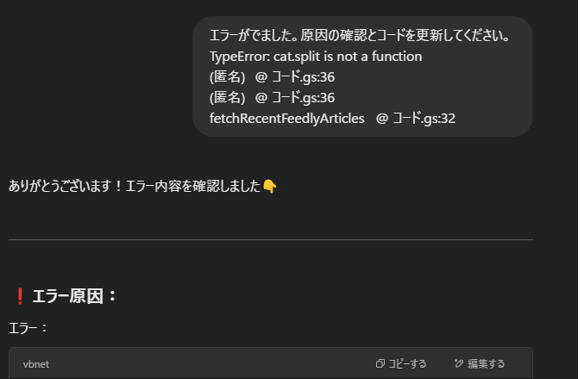

エラーが出ることもあるので、そうなったらそのエラーメッセージをコピーしてSheets Makerに貼り付け、「原因を確認してコードを修正してください」と依頼してみましょう。

・FeedlyのユーザーIDやアクセストークンが分からない… → Sheets Makerに取得方法を質問

・取得する記事の期間を絞りたい → 「過去3日以内の記事だけ取得したい」と依頼

・フォルダ名も出力したい → 「フォルダ列を追加して、対応するフォルダ名を出力してほしい」と依頼

・取得件数を増やしたい → 「取得上限を100件から5000件に変更して」と依頼

・実行時エラー発生! → エラー内容を伝えて修正を依頼

Step 3: スプレッドシートへの自動出力

最後に、整形済みのURLリストをGoogleスプレッドシートに自動で転送する処理を実装します。

ここでは、Google Apps Scriptを利用して、特定のスプレッドシートに対して定期的にAPIから取得したURLを上書きまたは追加する仕組みを構築します。

私が実際にこのプロセスを組んだ際、スクリプトのトリガー設定を行うことで、毎日自動的に最新情報が更新される環境を実現でき、作業効率が格段にアップしたと感じました。

この自動化の仕組みは、情報の漏れや手動入力ミスを防ぎ、「信頼性の高いデータ管理」を実現するために非常に有効です。

活用のポイントと私の体験談

この自動出力手順を実際に導入してみると、Feedlyに登録している複数のサイトの最新記事URLが、一括でGoogleスプレッドシートに出力されるため、毎日の情報収集作業が劇的に効率化されました。

「定期的な自動更新機能」により、情報の鮮度が保たれ、広告バナーの作成やマーケティング戦略の立案においても、最新のデータに基づいた迅速な意思決定が可能になりました。

私自身、この仕組みを導入してからは、以前は手作業で行っていたURL収集作業に費やしていた時間を他の考える業務に充てることができ、大変満足しています。

まとめ

Feedlyの登録サイトから最新記事のURLを自動でスプレッドシートに出力する手順は、情報収集の効率化とデータ管理の精度向上を実現する画期的な方法です。

また、私自身がこの手法を実践した経験から、自動化システムの導入は、業務効率化に直結することを実感しています。

これから情報収集やマーケティング業務を効率化したい方にお勧めです。

最新の情報技術を活用し、手間を省いたスマートなデータ管理で、業務効率のさらなる向上を目指しましょう。

また、このようなAIや自動化によって業務効率化や、マーケティングの仕組み改善によるROAS改善の相談をご希望の方は毎月3社限定で無料相談を受け付けています。